一 前言

對于正則表達式,相信很多人都知道,但是很多人的第一感覺就是難學,因為看第一眼時,覺得完全沒有規律可尋,而且全是一堆各種各樣的特殊符號,完全不知所云。

其實只是對正則不了解而以,了解了你就會發現,原來就這樣啊正則所用的相關字符其實不多,也不難記,更不難懂,唯一難的就是組合起來之后,可讀性比較差,而且不容易理解,本文旨在讓大家對正則有一個基本的了解,能看得懂簡單的正則表達式,寫得出簡單的正則表達式,用以滿足日常開發中的需求即可。

0/d{2}-/d{8}|0/d{3}-/d{7} 先來一段正則,如果你對正則不了解,是不是完全不知道這一串字符是什么意思?這不要緊文章會詳細解釋每個字符的含義的。

1.1 什么是正則表達式

正則表達式是一種特殊的字符串模式,用于匹配一組字符串,就好比用模具做產品,而正則就是這個模具,定義一種規則去匹配符合規則的字符。

1.2 常用的正則匹配工具

在線匹配工具:

1 http://www.regexpal.com/

2 http://rubular.com/

正則匹配軟件

McTracer

用過幾個之后還是覺得這個是最好用的,支持將正則導成對應的語言如java C# js等還幫你轉義了,Copy直接用就行了很方便,另外支持把正則表達式用法解釋,如哪一段是捕獲分組,哪段是貪婪匹配等等,總之用起來 So Happy .

二 正則字符簡單介紹

2.1 元字符介紹

"^" :^會匹配行或者字符串的起始位置,有時還會匹配整個文檔的起始位置。

"$" :$會匹配行或字符串的結尾

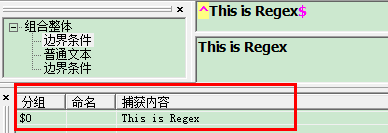

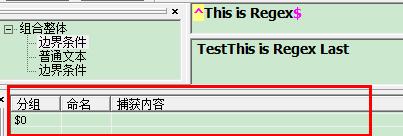

如圖

而且被匹配的字符必須是以This開頭有空格也不行,必須以Regex結尾,也不能有空格與其它字符

"/b" :不會消耗任何字符只匹配一個位置,常用于匹配單詞邊界 如 我想從字符串中"This is Regex"匹配單獨的單詞 "is" 正則就要寫成 "/bis/b"

/b 不會匹配is 兩邊的字符,但它會識別is 兩邊是否為單詞的邊界

"/d": 匹配數字,

例如要匹配一個固定格式的電話號碼以0開頭前4位后7位,如0737-5686123 正則:^0/d/d/d-/d/d/d/d/d/d/d$ 這里只是為了介紹"/d"字符,實際上有更好的寫法會在 下面介紹。

"/w":匹配字母,數字,下劃線.

例如我要匹配"a2345BCD__TTz" 正則:"/w+" 這里的"+"字符為一個量詞指重復的次數,稍后會詳細介紹。

"/s":匹配空格

例如字符 "a b c" 正則:"/w/s/w/s/w" 一個字符后跟一個空格,如有字符間有多個空格直接把"/s" 寫成 "/s+" 讓空格重復

".":匹配除了換行符以外的任何字符

這個算是"/w"的加強版了"/w"不能匹配 空格 如果把字符串加上空格用"/w"就受限了,看下用 "."是如何匹配字符"a23 4 5 B C D__TTz" 正則:".+"

"[abc]": 字符組 匹配包含括號內元素的字符

這個比較簡單了只匹配括號內存在的字符,還可以寫成[a-z]匹配a至z的所以字母就等于可以用來控制只能輸入英文了,

2.2 幾種反義

寫法很簡單改成大寫就行了,意思與原來的相反,這里就不舉例子了

"/W" 匹配任意不是字母,數字,下劃線 的字符

"/S" 匹配任意不是空白符的字符

"/D" 匹配任意非數字的字符

"/B" 匹配不是單詞開頭或結束的位置

"[^abc]" 匹配除了abc以外的任意字符

2.3 量詞

先解釋關于量詞所涉及到的重要的三個概念

貪婪(貪心) 如"*"字符 貪婪量詞會首先匹配整個字符串,嘗試匹配時,它會選定盡可能多的內容,如果 失敗則回退一個字符,然后再次嘗試回退的過程就叫做回溯,它會每次回退一個字符,直到找到匹配的內容或者沒有字符可以回退。相比下面兩種貪婪量詞對資源的消耗是最大的,

懶惰(勉強) 如 "?" 懶惰量詞使用另一種方式匹配,它從目標的起始位置開始嘗試匹配,每次檢查一個字符,并尋找它要匹配的內容,如此循環直到字符結尾處。

占有 如"+" 占有量詞會覆蓋事個目標字符串,然后嘗試尋找匹配內容 ,但它只嘗試一次,不會回溯,就好比先抓一把石頭,然后從石頭中挑出黃金

"*"(貪婪) 重復零次或更多

例如"aaaaaaaa" 匹配字符串中所有的a 正則: "a*" 會出到所有的字符"a"

"+"(懶惰) 重復一次或更多次

例如"aaaaaaaa" 匹配字符串中所有的a 正則: "a+" 會取到字符中所有的a字符, "a+"與"a*"不同在于"+"至少是一次而"*" 可以是0次,

稍后會與"?"字符結合來體現這種區別

"?"(占有) 重復零次或一次

例如"aaaaaaaa" 匹配字符串中的a 正則 : "a?" 只會匹配一次,也就是結果只是單個字符a

"{n}" 重復n次

例如從"aaaaaaaa" 匹配字符串的a 并重復3次 正則: "a{3}" 結果就是取到3個a字符 "aaa";

"{n,m}" 重復n到m次

例如正則 "a{3,4}" 將a重復匹配3次或者4次 所以供匹配的字符可以是三個"aaa"也可以是四個"aaaa" 正則都可以匹配到

"{n,}" 重復n次或更多次

與{n,m}不同之處就在于匹配的次數將沒有上限,但至少要重復n次 如 正則"a{3,}" a至少要重復3次

把量詞了解了之后之前匹配電話號碼的正則現在就可以改得簡單點了^0/d/d/d-/d/d/d/d/d/d/d$ 可以改為"^0/d+-/d{7}$"。

這樣寫還不夠完美如果因為前面的區號沒有做限定,以至于可以輸入很多們,而通常只能是3位或者4位,

現在再改一下 "^0/d{2,3}-/d{7}"如此一來區號部分就可以匹配3位或者4位的了

2.4 懶惰限定符

"*?" 重復任意次,但盡可能少重復

如 "acbacb" 正則 "a.*?b" 只會取到第一個"acb" 原本可以全部取到但加了限定符后,只會匹配盡可能少的字符 ,而"acbacb"最少字符的結果就是"acb"

"+?" 重復1次或更多次,但盡可能少重復

與上面一樣,只是至少要重復1次

"??" 重復0次或1次,但盡可能少重復

如 "aaacb" 正則 "a.??b" 只會取到最后的三個字符"acb"

"{n,m}?" 重復n到m次,但盡可能少重復

如 "aaaaaaaa" 正則 "a{0,m}" 因為最少是0次所以取到結果為空

"{n,}?" 重復n次以上,但盡可能少重復

如 "aaaaaaa" 正則 "a{1,}" 最少是1次所以取到結果為 "a"

三 正則進階

3.1 捕獲分組

先了解在正則中捕獲分組的概念,其實就是一個括號內的內容 如 "(/d)/d" 而"(/d)" 這就是一個捕獲分組,可以對捕獲分組進行 后向引用 (如果后而有相同的內容則可以直接引用前面定義的捕獲組,以簡化表達式) 如(/d)/d/1 這里的"/1"就是對"(/d)"的后向引用

那捕獲分組有什么用呢看個例子就知道了

如 "zery zery" 正則 /b(/w+)/b/s/1/b 所以這里的"/1"所捕獲到的字符也是 與(/w+)一樣的"zery",為了讓組名更有意義,組名是可以自定義名字的

"/b(?<name>/w+)/b/s/k<name>/b" 用"?<name>"就可以自定義組名了而要后向引用組時要記得寫成 "/k<name>";自定義組名后,捕獲組中匹配到的值就會保存在定義的組名里

下面列出捕獲分組常有的用法

"(exp)" 匹配exp,并捕獲文本到自動命名的組里

"(?<name>exp)" 匹配exp,并捕獲文本到名稱為name的組里

"(?:exp)" 匹配exp,不捕獲匹配的文本,也不給此分組分配組號

以下為零寬斷言

"(?=exp)" 匹配exp前面的位置

如 "How are you doing" 正則"(?<txt>.+(?=ing))" 這里取ing前所有的字符,并定義了一個捕獲分組名字為 "txt" 而"txt"這個組里的值為"How are you do";

"(?<=exp)" 匹配exp后面的位置

如 "How are you doing" 正則"(?<txt>(?<=How).+)" 這里取"How"之后所有的字符,并定義了一個捕獲分組名字為 "txt" 而"txt"這個組里的值為" are you doing";

"(?!exp)" 匹配后面跟的不是exp的位置

如 "123abc" 正則 "/d{3}(?!/d)"匹配3位數字后非數字的結果

"(?<!exp)" 匹配前面不是exp的位置

如 "abc123 " 正則 "(?<![0-9])123" 匹配"123"前面是非數字的結果也可寫成"(?!</d)123"

四 正則實戰

正則在做驗證,與數據過濾時體現的威力是巨大的,我想用過的朋友都知道,下面我們把剛剛了解的全部結合起來做一次實戰 做數據采集用正則過濾Html標簽并取相應的數據

我們的戰場就選在博客園吧,假設現在要采集博客園首頁的所有文章信息 包括文章標題,鏈接接 作者博客地址,文章簡介,文章發布時間,閱讀數據,評論數 ,推薦數。

先看博客園文章的Html格式

<div class="post_item"><div class="digg"> <div class="diggit" onclick="DiggIt(3439076,120879,1)"> <span class="diggnum" id="digg_count_3439076">4</span> </div> <div class="clear"></div> <div id="digg_tip_3439076" class="digg_tip"></div></div> <div class="post_item_body"> <h3><a class="titlelnk" href="http://www.cnblogs.com/swq6413/p/3439076.html" target="_blank">分享完整的項目工程目錄結構</a></h3> <p class="post_item_summary"><a href="http://www.cnblogs.com/swq6413/" target="_blank"><img width="48" height="48" class="pfs" src="http://pic.cnitblog.com/face/142964/20131116170946.png" </p> <div class="post_item_foot"> <a href="http://www.cnblogs.com/swq6413/" class="lightblue">七少爺</a> 發布于 2013-11-23 15:48 <span class="article_comment"><a href="http://www.cnblogs.com/swq6413/p/3439076.html#commentform" 評論(4)</a></span><span class="article_view"><a href="http://www.cnblogs.com/swq6413/p/3439076.html" class="gray">閱讀(206)</a></span></div></div><div class="clear"></div></div>

通過構造一個Http請求來取到數據并對數據進行相應處理得到關鍵信息,在過濾Html標簽取文章時正則的強大的威力就體現出來了,

正則的知識點也都基本用上了比如 "/s /w+ . * ? "還有捕獲分組,零寬斷言等等。喜歡的朋友可以試一試,然后自己看如何通過正則取相應數據的,代碼中的正則都是很基本簡單的,其意思與用法都在上文中詳細寫了。

class Program { static void Main(string[] args) { string content = HttpUtility.HttpGetHtml(); HttpUtility.GetArticles(content); } } internal class HttpUtility { //默認獲取第一頁數據 public static string HttpGetHtml() { HttpWebRequest request = (HttpWebRequest)WebRequest.Create("http://www.cnblogs.com/"); request.Accept = "text/plain, */*; q=0.01"; request.Method = "GET"; request.Headers.Add("Accept-Language", "zh-cn,zh;q=0.8,en-us;q=0.5,en;q=0.3"); request.ContentLength = 0; request.Host = "www.cnblogs.com"; request.UserAgent = "Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.1 (KHTML, like Gecko) Maxthon/4.1.3.5000 Chrome/26.0.1410.43 Safari/537.1"; HttpWebResponse response = (HttpWebResponse)request.GetResponse(); Stream responStream = response.GetResponseStream(); StreamReader reader = new StreamReader(responStream, Encoding.UTF8); string content = reader.ReadToEnd(); return content; } public static List<Article> GetArticles(string htmlString) { List<Article> articleList = new List<Article>(); Regex regex = null; Article article = null; regex = new Regex("<div class=/"post_item/">(?<content>.*?)(?=<div class=/"clear/">" + @"</div>/s*</div>)", RegexOptions.Singleline); if (regex.IsMatch(htmlString)) { MatchCollection aritcles = regex.Matches(htmlString); foreach (Match item in aritcles) { article = new Article(); //取推薦 regex = new Regex( "<div class=/"digg/">.*<span.*>(?<digNum>.*)" + @"</span>" + ".*<div class=/"post_item_body/">", RegexOptions.Singleline); article.DiggNum = regex.Match(item.Value).Groups["digNum"].Value; //取文章標題 需要去除轉義字符 regex = new Regex("<h3>(?<a>.*)</h3>", RegexOptions.Singleline); string a = regex.Match(item.Value).Groups["a"].Value; regex = new Regex("<a//s.*href=/"(?<href>.*?)/".*>(?<summary>.*)</a>", RegexOptions.Singleline); article.AritcleUrl = regex.Match(a).Groups["href"].Value; article.AritcleTitle = regex.Match(a).Groups["summary"].Value; //取作者圖片 regex = new Regex("<a.*>(?<img><img[^>].*>)</a>", RegexOptions.Singleline); article.AuthorImg = regex.Match(item.Value).Groups["img"].Value; //取作者博客URL及鏈接的target屬性 regex = new Regex("<a//s*?href=/"(?<href>.*)/"//s*?target=/"(?<target>.*?)/">.*</a>", RegexOptions.Singleline); article.AuthorUrl = regex.Match(item.Value).Groups["href"].Value; string urlTarget = regex.Match(item.Value).Groups["target"].Value; //取文章簡介 //1 先取summary Div中所有內容 regex = new Regex("<p class=/"post_item_summary/">(?<summary>.*)</p>", RegexOptions.Singleline); string summary = regex.Match(item.Value).Groups["summary"].Value; //2 取簡介 regex = new Regex("(?<indroduct>(?<=</a>).*)", RegexOptions.Singleline); article.AritcleInto = regex.Match(summary).Groups["indroduct"].Value; //取發布人與發布時間 regex = new Regex( "<div class=/"post_item_foot/">//s*<a.*?>(?<publishName>.*)</a>(?<publishTime>.*)<span class=/"article_comment/">", RegexOptions.Singleline); article.Author = regex.Match(item.Value).Groups["publishName"].Value; article.PublishTime = regex.Match(item.Value).Groups["publishTime"].Value.Trim(); //取評論數 regex = new Regex( "<span class=/"article_comment/"><a.*>(?<comment>.*)</a></span><span class=/"article_view/">", RegexOptions.Singleline); article.CommentNum = regex.Match(item.Value).Groups["comment"].Value; //取閱讀數 regex = new Regex("<span//s*class=/"article_view/"><a.*>(?<readNum>.*)</a>", RegexOptions.Singleline); article.ReadNum = regex.Match(item.Value).Groups["readNum"].Value; articleList.Add(article); } } return articleList; } public static string ClearSpecialTag(string htmlString) { string htmlStr = Regex.Replace(htmlString, "/n", "", RegexOptions.IgnoreCase); htmlStr = Regex.Replace(htmlStr, "/t", "", RegexOptions.IgnoreCase); htmlStr = Regex.Replace(htmlStr, "/r", "", RegexOptions.IgnoreCase); htmlStr = Regex.Replace(htmlStr, "/"", "'", RegexOptions.IgnoreCase); return htmlStr; } } public class Article { /// <summary> /// 文章標題 /// </summary> public string AritcleTitle { get; set; } /// <summary> /// 文章鏈接 /// </summary> public string AritcleUrl { get; set; } /// <summary> /// 文章簡介 /// </summary> public string AritcleInto { get; set; } /// <summary> /// 作者名 /// </summary> public string Author { get; set; } /// <summary> /// 作者地址 /// </summary> public string AuthorUrl { get; set; } /// <summary> /// 作者圖片 /// </summary> public string AuthorImg { get; set; } /// <summary> /// 發布時間 /// </summary> public string PublishTime { get; set; } /// <summary> /// 推薦數 /// </summary> public string DiggNum { get; set; } /// <summary> /// 評論數 /// </summary> public string CommentNum { get; set; } /// <summary> /// 閱讀數 /// </summary> public string ReadNum { get; set; } }正則部分可能寫得不很完美,但至少也匹配出來了,另外因為自己也是剛接觸正則,也只能寫出這種比較簡單的正則。還望大家海涵~~

五 總結

正則其實并不難,了解每個符號的意思后,自己馬上動手試一試多寫幾次自然就明白了,正則是出了名的坑多,隨便少寫了個點就匹配不到數據了,我也踩了很多坑,踩著踩著就踩出經驗了。

本文也只是對正則做了很基本的介紹,還有很多正則的字符沒有介紹,只是寫了比較常用的一些。如有錯誤之處,還望在評論中指出,我會馬上修改。

好了,關于正則表達式知識就給大家介紹這么多,希望對大家有所幫助,如果大家有任何疑問歡迎給我留言,小編會及時回復大家的,在此也非常感謝大家對VEVB武林網網站的支持!

新聞熱點

疑難解答